“The illusion of thinking”, l’étude d’Apple qui questionne l’intelligence des IA génératives

- Par

Pollen

- Publié le

- 30/06/2025

- Temps de lecture

- 4min

C’est une étude qui n’a pas eu le relais escompté dans la presse européenne. Et pourtant, le très complet rapport “The illusion of thinking” d’Apple dissèque avec brio la nature fragile des modèles de langage comme GPT-4, Claude 3.7 Sonnet ou encore DeepSeek-R1.

Tous sont des LRM (Large Reasoning Model), des super LLM conçus pour mener des raisonnements complexes en exploitant la technique du Chain-of-Thought.

Mais d’après Apple, ces modèles ne raisonnent justement pas. Ils sont des machines probabilistes, parfaitement entraînées à prédire le prochain mot mais tout à fait incapables de penser par elles-mêmes. Et c’est tout le problème.

Le problème du loup, de la chèvre et du chou

Les ingénieurs d’Apple intelligence ont mené une batterie de tests pour tenter de comprendre si ces modèles d’IA générative disposaient d’un système leur permettant véritablement de raisonner. Pour cela, ils se sont appuyés sur des expériences pour le moins complexes et originales comme les fameuses énigmes de traversée de rivière, ou la Tour de Hanoï.

Contrairement aux modèles mathématiques auxquels les IA sont habituées, ces problèmes logiques ont deux avantages :

D’abord, ils permettent de travailler autour de différents degrés de complexité et d’ambiguïté. Ensuite, ils ont pour objectif d’évaluer, au-delà de la réponse finale, les étapes clefs du raisonnement.

Et la conclusion est surprenante.

Lorsque le problème devient trop complexe, tous les modèles - y compris les LRM conçus sur des méthodes de raisonnements intermédiaires - échouent. Au-delà d’un certain seuil de difficulté, les LRM abandonnent tout simplement leur chemin de réflexion. Et même lorsque l’algorithme de résolution leur est fourni, ces derniers commettent parfois des erreurs grossières.

“Un enfant de 7 ans aurait pu faire mieux”

Mais de quelle complexité parle-t-on ?

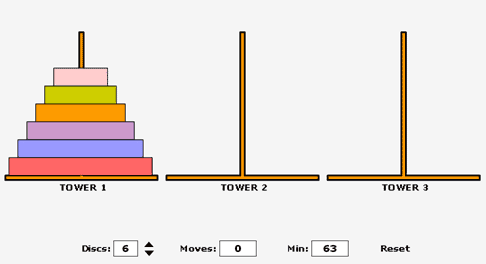

La tour de Hanoï est un jeu classique, composé de trois “tours” et de disques de tailles différentes (voir la photo ci-dessous) que nous connaissons tous. L’objectif est simple : déplacer tous les disques au niveau de la troisième tour, sans jamais placer un disque plus grand sur un disque plus petit.

Gary Marcus, psychologue américain qui est revenu sur ce rapport constate :

“Avec un peu de pratique, un enfant de sept ans intelligent et patient peut y arriver - et pour un ordinateur, c’est un exercice qui ne présente aucune difficulté. N’importe quel étudiant en première année d’informatique devrait être capable de réaliser un programme qui pourrait systématiquement résoudre le jeu.”

Alors, comment les modèles les plus avancés ont-ils échoué ?

Apple, LeCun et les autres l’avaient prédit : vers une rupture de paradigme ?

Ce rapport n’arrive pas seul.

Il fait écho à de précédentes études menées par les mêmes ingénieurs d’Apple, mais également aux critiques formulées de longue date par Yann LeCun, chief scientist chez Meta. Et si notre intuition de départ, celle qu’il serait possible de faire émerger l’intelligence par une simple accumulation de données, n’était pas la bonne ?

The imitation game

C’est peut être là que se tient la réponse.

Les pères fondateurs, Alan Turing en tête, Minsky & McCarty après lui formulaient déjà très clairement cette idée aux premières heures de l’IA. “Il faudra s’inspirer du fonctionnement de l’être humain pour faire des machines qui fonctionnent”.

Oui, mais imiter n’est pas créer, au même titre qu’exécuter ne signifie pas comprendre, et c’est sans doute là tout le propre de l’intelligence artificielle.

Une IA qui répète, qui effectue de la reconnaissance de motifs et de la prédiction, parfaitement entrainée sur des benchmark mathématiques mais pourtant incapables de résoudre une énigme dont les solutions sont accessibles sur internet. Pour de nombreux penseurs de l’IA, comme Luc Julia, la probabilité que de tels modèles avancés atteignent prochainement l’intelligence collective reste encore largement improbable.

Repenser notre vision de l’IA : un outil d’accès à la connaissance, jamais une fin en soi.

Oui l’IA est imbattable quand il s’agit de restituer de l’information qu’elle a ingurgitée dans ses données d’entrainement, de réciter par coeur ou encore d’imiter, mais elle ne crée pas. En cela, elle peut être un formidable outil d’aide à la décision et d’accès à la connaissance. Elle peut accompagner les équipes sur des cas d’usages spécifiques et engranger de larges gains de productivité, mais elle n’invente pas.

Si l’innovation, reste aux mains de l’humain, l’IA peut tout de même nous aider. L’étude d’Apple ne dit d’ailleurs pas que l’IA est inutile si elle est utilisée à bon escient. À l’heure où l’intelligence artificielle refaçonne l’éducation et nos modes de travail, la transition progressive vers une “hybridation intelligente” - entre intelligence humaine et puissance de calcul des IA - apporte nécessairement des perspectives séduisantes comme l’automatisation de tâches à faible valeur ajoutée ou encore les gains de productivité attendus par 75% des talents et entreprises françaises. Mais pour créer des systèmes plus fiables, mieux encadrés, et surtout mieux compris, il devient essentiel de nous former aux limites fondamentales des LLM : celles de modèles de langages qui ne peuvent à ce jour se substituer au facteur humain.